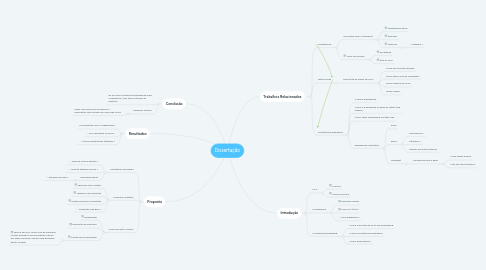

1. Conclusão

1.1. Dá pra usar contextual embeddings para coreference, mas tem q otimizar as features

1.2. Trabalhos futuros

1.2.1. Fazer uma forma de incorporar o perceptron estruturado em uma rede única

2. Resultados

2.1. Comparação com o LeaderBoard

2.2. Pq o resultado foi esse ?

2.3. Outras arquiteturas testadas ?

3. Proposta

3.1. Arquitetura escolhida

3.1.1. Falar de outras opções ?

3.1.2. Quanto detalhe colocar ?

3.1.3. hiperparametros

3.1.3.1. detalhar escolha ?

3.2. Análise do Dataset

3.2.1. Tamanho dos clusters

3.2.2. Tamanho das menções

3.2.3. Distancia entre as menções

3.2.4. Dispersão dos Bins ?

3.3. Como foi feito o treino

3.3.1. Embedding

3.3.2. Detecção de menções

3.3.3. Pastas desconsideradas

3.3.3.1. Parece ser erro, já que não há nenhuma cluster anotado e uma inspeção manual em alguns arquivos mostra que deveriam existir clusters

4. Trabalhos Relacionados

4.1. Coreference

4.1.1. Descrever bem o problema

4.1.1.1. Leaderboard atual

4.1.1.2. Exemplo

4.1.1.3. Métricas

4.1.1.3.1. Detalhar ?

4.1.2. Tipos de solução

4.1.2.1. Em etapas

4.1.2.2. End-to-end

4.2. Latent Trees

4.2.1. Descrição do paper de 2014

4.2.1.1. O que são árvores latentes

4.2.1.2. Como gerar árvores candidatas

4.2.1.3. Como selecionar arcos

4.2.1.4. Large Margin

4.3. Contextual Embedding

4.3.1. O que é embedding

4.3.2. Como o embedding é usado na latent tree original

4.3.3. Como fazer embedding context-free

4.3.4. embedding contextual

4.3.4.1. Elmo

4.3.4.2. BERT

4.3.4.2.1. Transformer ?

4.3.4.2.2. Attention ?

4.3.4.2.3. Ganhos em outras tarefas

4.3.4.3. SpanBert

4.3.4.3.1. Diferenças para o BERT

5. Introdução

5.1. NLP

5.1.1. O que é

5.1.2. Como funciona

5.2. Coreference

5.2.1. Definição rápida

5.2.2. Conll 2011/2012

5.2.3. Usar diagramas ?

5.3. Contextual embedding

5.3.1. Como a solução de 2012 usa embedding

5.3.2. o que é contextual embedding

5.3.3. Como pode ajudar ?