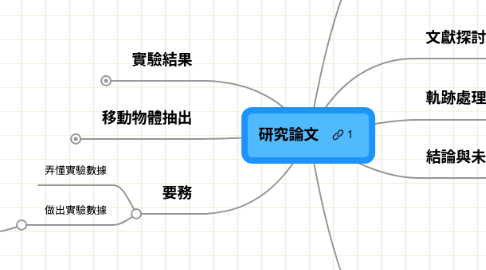

1. 實驗結果

1.1. 系統環境

1.1.1. client-server

1.1.2. 能在瀏覽器上執行

1.1.2.1. 經過些許修改後 就能讓行動裝置使用

1.2. 系統畫面

1.2.1. 意見

1.2.1.1. 只需要旋轉Y軸

1.2.2. 畫面內容

1.2.2.1. 2D描繪

1.2.2.1.1. 繪畫軌跡

1.2.2.1.2. 符合b-spline控制點

1.2.2.2. 3D顯示

1.2.2.2.1. 搜尋的軌跡

1.2.2.2.2. 結果的軌跡

1.2.2.2.3. 軌跡顏色

1.2.2.3. 選擇背景

1.2.2.3.1. 尋找XY相似

1.2.2.4. 速度相似

1.2.2.4.1. ?

1.2.2.5. 搜尋結果畫面

1.2.2.5.1. 框出物件

1.2.2.5.2. 顯示時間

1.2.2.5.3. 魚眼效果

1.2.2.6. 物件相似

1.3. 處理時間

1.4. 評比

1.4.1. 如何做performance evaluation

1.4.2. 別人如何evaluate ground truth

1.4.3. 可以cut掉超過但空白的部份

1.4.4. http://www.hitech-projects.com/euprojects/cantata/datasets_cantata/dataset.html

1.4.5. http://www-sop.inria.fr/orion/ETISEO/download.htm#video_data

1.4.6. 可用

1.4.6.1. http://www-prima.inrialpes.fr/PETS04/caviar_data.html

1.4.6.2. ftp://motinas.elec.qmul.ac.uk/pub/av_people/

1.4.6.3. ftp://motinas.elec.qmul.ac.uk/pub/single_face/

1.4.6.4. ftp://motinas.elec.qmul.ac.uk/pub/multi_face/

1.4.6.5. http://www-sop.inria.fr/orion/ETISEO/download.htm#video_data

1.4.7. 為何???結果不一樣,沒有做好的原因

2. 移動物體抽出

2.1. BGS

2.1.1. GMM BGS using cuda

2.1.2. Optical Flow on intensity

2.1.2.1. Horn-Schunck

2.1.3. CIE76 color difference

2.1.3.1. L*a*b space

2.1.4. sum of above

2.1.5. mean-shift segmentation

2.1.6. Graph-Based_Image_Segmentation

2.2. shadow subtraction

2.2.1. LrTextureShadow

2.3. tracking

2.3.1. Kalman filter

2.3.2. openTLD

3. 要務

3.1. 弄懂實驗數據

3.2. 做出實驗數據

3.2.1. CAVIAR專案中包含了兩組測試集,Case 1測試集中包含了21個由大廳斜上方拍攝的影片,其中共有104個移動行人,在左下角的強烈陽光照射影響之下,系統偵測到了75個,追蹤面積準確率為0.7704。Case 2測試集包含兩組由走廊正面與側面拍攝,共52個影片,其中包含了394個移動行人,系統偵測到了355個,追蹤面積準確率為0.8172。BEHAVE專案則有19個行人,系統偵測到了15個,追蹤面積準確率為0.8161。

4. 緒論

4.1. 系統貢獻

4.1.1. 以軌跡尋找物體

4.1.1.1. 目前並沒有3D呈現

4.1.1.1.1. 多年前的研究的限制是什麼

4.1.1.2. 更好的表達力

4.1.1.3. 3D呈現可調整速度

4.1.1.4. 可從曲線拉動軌跡作進一步搜尋

4.1.2. 以物體外觀尋找軌跡

4.1.2.1. 因為光影變化etc.辨識不易 若結合軌跡搜尋將更有用

4.1.2.1.1. 在章節後面附註

4.1.3. 結合各作法

4.1.3.1. 就我們所知,並沒有一個結合OO的完整研究 各單元實作上是先選較簡單的做法,並非本篇貢獻,必要時仍可抽換

5. 文獻探討

5.1. BGS

5.1.1. Video object segmentation by motion-based sequential feature clustering

5.1.1.1. 一般motion-based的研究通常會被optical flow的error所影響,但這邊提出的方法可以避免這個問題: (1) 用的是邊點跟邊界,比較不會受到noise影響 (2) 我們只將4000~6000這麼多的移動向量fit到兩種model裏面

5.1.2. Learning color and locality cues for moving object detection and segmentation

5.1.2.1. (a)先經由optical flow估計鏡頭的global motion,然後在物體跟鏡頭移動方向差別比較大的frame抽取出keyframe。(b)將明顯的特徵抽出(c)sub-object (d)依據顏色特徵propagate到整個object去

5.2. 陰影移除

5.2.1. Background Subtraction and Shadow Detection in Grayscale Video Sequences

5.2.1.1. (1)式是建立BG model的公式,對某個pixel來說,先取一些frame,這些frame的此pixel與所有frame相差是小於兩倍標準差的。然後,取他的max、min跟difference

5.2.2. Improved Shadow Removal for Robust Person Tracking in Surveillance Scenarios

5.2.2.1. 他的主要方法包含兩個部分,包括色度特徵跟紋理特徵。假設陰影的部分是比較暗的背景,紋理跟原本的背景是一樣的。 系統的五步驟直接看[Fig.2] (a) 先做前景背景分割 (b) 依據色度來選擇候選區域 (c) 候選區域 (d) 計算梯度跟背景梯度比對 (e) 每個區域的踢度 (f) 最後去掉陰影的結果

5.2.3. Shadow Removal with Blob-Based Morphological Reconstruction for Error Correction

5.2.3.1. 利用前景背景圖像差異 移除某段差意區間中的像素

5.3. tracking

5.3.1. Object-Tracking: A survey

5.3.1.1. 物件追蹤可能會遇到的問題 *不連貫的物體移動 *物體或是場景本身外型的改變 *物體本身可能也會扭曲變形 *還有鏡頭的移動等

5.3.1.1.1. 物件追蹤的幾個關鍵步驟 *移動中的物體偵測 *在影格跟影格之間追蹤該物體 *分析物體的動作行為等 ex: 動物追蹤時較不會遇到動物突然劇烈轉向、加減速等等

5.3.2. Online learning of robust object detectors during unstable tracking

5.3.2.1. "在一個不穩定的環境(可能背景變動是很大的)裡面追蹤一個不確定的物體(user可以自己框) " "Adaptive method在追蹤過程中會持續更新物體的特徵,但付出的代價是如果更新錯誤會一直追到錯的物體上面去。 這邊他採用的是Adaptive的方法,不同的地方是他同時應用了兩個程序(成長跟修剪) 這兩個程序都會誤判,系統會結合這兩個程序的結果來維持穩定性。 追蹤過程中會持續作learning,當物體消失又出現的時候,已經被學習到的偵測器會根據之前學習到的特徵重新初始化。" "可以抗鏡頭移動、剪接等 物體有時後會被其他物體遮住剩下一部份,也有可能突然出現或消失。 他想做的是Long-term,也就是不限影片長度,Online是不需要影片後面的資料,影片撥到哪就追到哪。"

5.3.3. Moving object detection and tracking system

5.3.3.1. 當算出來的時候,可以依據各個區塊加上預測的移動向量計算一個prediction image,將預測跟實際的質心座標可以建構共生矩陣。Row代表新的frame的物件區塊位置,column代表預測的image。 1-區塊的分割錯誤、2-合併、分割區塊、3-區塊相互通過 在人數改變的(而且不是單純區塊分合)時候回溯回去建構他的軌跡。

5.3.4. Object Tracking by Asymmetric Kernel Mean Shift with Automatic Scale and Orientation Selection

5.3.4.1. 在mean-shift tracking上面做加強。 Mean-shift: 用來找feature-space中在某種機率分佈函數下的極值,也就是說,在未知他的機率分佈函數之下要找到眾數值 Mean-shift tracking: 先根據color histogram建立一個confidence map對應每個pixel是否屬於目標的機率,然後就可以利用mean-shift來找該object最有可能出現在哪裡的peak值

5.3.5. Interactive Offline Tracking for Color Objects

5.3.5.1. 紀錄中心點、寬跟高,並且把RGB各分成8x8x8的bin。做tracking的時候user指定物件開始追蹤的點跟結束點,然後編輯中間的keyframe。

5.3.5.2. 我們把user介入的frame當keyframe

5.4. Video Search

5.4.1. 現有系統

5.4.1.1. 文字搜尋

5.4.1.1.1. index流程

5.4.1.1.2. search

5.4.2. Video Retrieval using Spatio-Temporal Descriptors

5.4.2.1. 將這些顏色做分群,並且加入時間軸就會像右邊這個立體空間這樣,有點像optical flow的感覺,之後就依據這個來搜尋,這些顏色光棒就稱之為Video Strands。

5.4.3. BilVideo-7:An MPEG-7- Compatible Video Indexing and Retrieval System

5.4.3.1. 範例image做內容搜尋、依據高階文字語意、還有跟我研究比較相關的利用影片中物件各時間所在位置關係,最後可以讓user結合各種query方式做複合查詢。

5.4.3.2. 同種類的query是可以分散到不同server同時做平行查詢,之後再合併起來以節省時間的。

5.4.3.3. 影片註解工具、系統會自動作一些簡單的物體抽出,user可以手動下註解。下面是搜尋介面

5.5. 軌跡處理與比對

5.5.1. Motion Trajectory Matching of Video Objects

5.5.1.1. 透過小波係數將軌跡拆解為子軌跡

5.5.1.2. (空間上的不變性):將曲線上的弧長正規化 (空間轉換):軌跡開始的位置 (空間中的旋轉):將主軸對齊X軸 (時間尺度):整個軌跡橫跨的時間 (時間轉換):開始時間

5.5.1.2.1. 做部分比對時候,提出幾種方法: (a) Strict: 順序一定要完全一樣 (b) Relative:順序一樣,中間可以有別的sub-trajectory (c) Loose partial:順序可不同

5.5.2. 在內涵式視訊擷取中 有關運動軌跡的有效表達與雙階層比對方法

5.5.2.1. 運動地圖

5.5.2.1.1. 徑。當運動軌跡經過某一巨方塊時,對應的位元以 1 來標示,反之以 0 標示,做XOR,忽略時間順序

5.5.2.2. 方向性軌跡

5.5.2.2.1. 用最近點來做有序比對

5.5.2.3. 雙向Hausdorff 距離

5.5.2.3.1. 每個點都尋找最近點

5.5.2.4. 平移縮放不變量比對

5.5.2.4.1. 正規化到長寬為1的矩形,重心置於原點

5.5.3. Trajectory Matching and Classification of Video Moving Objects

5.5.3.1. Levenshtein distance

5.5.3.1.1. compare the topological shapes and directions of trajectories

5.5.3.2. Trajectory relaxation matching

5.5.3.2.1. gain the statistical optimal matching.

5.5.3.3. gesture recognition system

5.5.3.4. surveillance system, abnormal behaviors

5.5.3.5. Hausdorff distance or Bottleneck Distance

5.5.3.5.1. Dynamic time wrapping

5.5.3.6. Classifying trajectories

5.5.4. Multi Feature Path Modeling for Video Surveillance

5.5.4.1. 用graph cut來分類

5.5.4.2. envlope boundary

5.5.5. Longest Common Subsequence

5.6. 物件比對

5.6.1. Study of sift descriptors for image matching based localization in urban street view context

5.6.1.1. CMRT09 - City Models, Roads and Traffic

6. 軌跡處理與比對

6.1. 異常偵測演算法之研究及其應用

6.1.1. 如果把那個點加進來model (PCA)會改變

6.2. curve fitting

6.2.1. spline

6.2.1.1. https://dl.dropbox.com/u/18090668/MindMap/11-8-6.jpg

6.2.1.2. Least-Squares

6.2.1.3. Smoothing

6.2.1.4. function value

6.2.2. cscvn

6.2.2.1. Choosing nodes in parametric curve interpolation

6.2.3. 為什麼不能通過提高多項式的次數來更好的擬合曲線呢

6.2.3.1. wiki

6.3. curve matching

6.3.1. https://dl.dropbox.com/u/18090668/MindMap/f.jpeg

6.3.2. Key point

6.3.3. Clockwise

6.3.4. 做回歸線之後算到線的距離/角度就可抗旋轉

6.3.4.1. 還可以知道旋轉角度

6.3.5. Hausdorff distance

6.3.5.1. 一個集合到離另一個集合最近的點的最大距離。

6.3.5.2. H(A,B)=Max(h(A,B),h(B,A))

6.3.5.3. h(A,B)=(d11+d12+d13+d14+d15)/5

6.3.6. 用多次方程fit之後比係數

6.3.7. Sampling Rate為兩倍最高頻已經夠

6.3.8. 類似高斯金字塔

6.4. 每一層做K-means cluster

7. 結論與未來展望

8. 結論

8.1. summarize

8.1.1. 貢獻1 2 3

8.1.1.1. 數據上

8.2. 結束討論

8.2.1. 我們已經做了OOXX

8.3. future work

8.3.1. 改正

8.3.2. 發展

8.3.2.1. 追蹤其他物體?

8.3.2.2. 拓展到不是監視器

8.3.2.3. 真正3D空間中

8.3.2.3.1. 結合深度感測

8.3.2.3.2. 多角度鏡頭

8.3.2.3.3. 如何輸入

8.4. CGW

8.4.1. 不用放英文TITLE