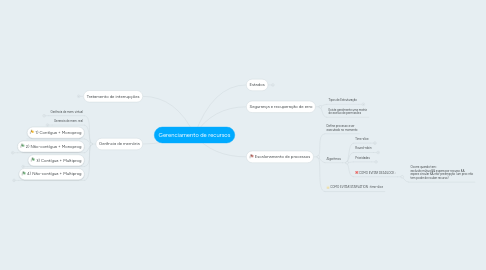

1. Tratamento de interrupções

1.1. Interrompe funcionamento do programa; podem ser assíncronas;

1.2. Cada interrupção tem um nível de prioridade

2. Gerência de memória

2.1. Gerência de mem. virtual

2.1.1. Pode ser maior que memória real

2.1.2. Dificulta a proteção do código

2.2. Gerencia de mem. real

2.2.1. Dividida em blocos de tam. fixos

2.2.1.1. Sem fragmentação (pq cada prog. tem tamanho fixo. Pode ter desperdício de memória)

2.2.2. Dividida em blocos da tam. variáveis

2.2.2.1. Com fragmentação (cada prog. aloca o espaço que ele precisa apenas)

2.2.2.2. Combate de fragmentação: realocação de memória

2.2.2.3. Facilita proteção do código

2.3. 1) Contígua + Monoprog

2.4. 2) Não-contígua + Monoprog

2.4.1. Overlay

2.4.1.1. Ocorre quando o tamanho do programa é maior que a memória. A solução é dividir o programa em fases (fixas e móveis), e alocar e desalocar da área de overlay sempre que precisar

2.5. 3) Contígua + Multiprog

2.5.1. Partição

2.5.1.1. 1) Cada programa tem um tamanho fixo na memória. Pode gastar memória sem precisar

2.5.1.2. 2) Cada programa tem alocado só a memória que vai precisar. Pode ter fragmentação da memória

2.5.2. Relocação dinâmica

2.5.2.1. Cálculo +simples de endereço feito por tradutor dinâmico: Endereço real = endereço lógico + registrador base

2.5.3. Swapping(time-slice)

2.5.3.1. Troca processos via interrupção para parecer que eles estão sendo executados ao mesmo tempo. Escalona pro prioridades

2.6. 4) Não-contígua + Multiprog

2.6.1. Paginação

2.6.1.1. Utiliza memória virtual para dividir programa em páginas que são armazenadas não necessariamente na ordem

2.6.1.2. Quando o programa é maior que a memória, precisa usar LRU (least recently used) pra armazenas as páginas em momória.

2.6.1.3. Endereço virtual é +complexo e feito pela DAT tbm.

2.6.1.3.1. Endereço real [ p ][ d ] p = endereço em memória d = depende do tamanho da memória

2.6.1.3.2. Tabela de mapeamento de pag. [ r ][ s ][ p ] r = bit que diz se tá em mem s = endereço em disco

2.6.1.3.3. Endereço lógica [ e-d ][ d ] e (+) RegBase = p

2.6.2. Segmentação

2.6.2.1. Divide o programa ainda mais: em segmentos, entaõ os blocos tem tamanhos variados

2.6.2.2. Maior proteção

2.6.3. Paginação + Segmentação

2.6.3.1. Usa os dois mapas de paginação e segmentação

2.6.3.2. Endereço lógico tem 3 níveis: segmento, página, deslocamento na página

3. Estados

3.1. Pronto

3.2. Executando

3.3. Bloqueado

3.4. Finalizado

4. Segurança e recuperação de erro

4.1. Tipos de Estruturação

4.1.1. Hierarquia

4.1.1.1. Nível pai usa serviços do nível filho

4.1.2. MV

4.1.2.1. SO's diferentes rodando no mesmo PC

4.1.3. SO Multiprocessado

4.1.3.1. 1) Arquitetura fortemente acoplada: processadores dividem 1 memória e io. É gerenciado por 1 SO

4.1.3.2. 2) Arquitetura fracamente acoplada: sistemas computacionais são independentes e usam seus próprios SO's com memória, io, eoscarai

4.1.4. SO distribuído

4.1.4.1. Mestre-escravo, simétrico, eoscarai. A presença da rede é transparente

4.1.5. SO OO

4.1.5.1. Servidores excluem e criam novos objetos. O kernel faz escalonamento e comunicação entre processos. Quem faz o resto são os objetos

4.2. Existe geralmente uma matriz de acesso de permissões

5. Escalonamento de processos

5.1. Define processo a ser executado no momento

5.2. Algoritmos

5.2.1. Time-slice

5.2.1.1. Quando o processo que está na fila entra no estado ~executando~, ele tem um tempo de intervalo (time-slice) para ser executado, pra não ocorrer Starvation

5.2.2. Round-robin

5.2.2.1. Faz o mesmo que o time-slice, mas a fila de processos é circular e sem uso de prioridades.

5.2.3. Prioridades

5.2.3.1. O escalonamento de processo pode executar em ordem de prioridade, mas pra evitar starvation, ele pode aumentar a prioridade do processo quanto maior é sua espera na fila de prontos

5.2.4. COMO EVITAR DEADLOCK :

5.2.4.1. Ocorre quando tem: exclusão mútua && espera por recurso && espera circular && não-preempção (um proc não tem poder de roubar recurso)