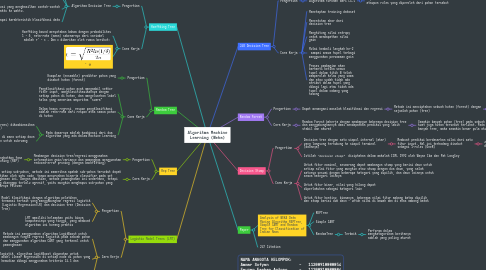

1. Hoeffding Tree

1.1. Pengertian

1.1.1. Algoritma Decision Tree

1.1.1.1. Incremental

1.1.1.2. Data Besar

1.1.1.3. Asumsi bahwa distribusi yang menghasilkan contoh-contoh tidak berubah dari waktu ke waktu.

1.1.1.4. Untuk mencapai karakteristik klasifikasi data stream

1.2. Cara Kerja

1.2.1. Hoeffding bound menyatakan bahwa dengan probabilitas 1 - δ, rata-rata (mean) sebenarnya dari variabel adalah r’ - ε . Dan ε diberikan oleh rumus berikut:

1.2.2. -

2. Random Tree

2.1. Pengertian

2.1.1. Kumpulan (ensemble) prediktor pohon yang disebut hutan (forest)

2.2. Cara Kerja

2.2.1. Pengklasifikasi pohon acak mengambil vektor fitur input, mengklasifikasikannya dengan setiap pohon di hutan, dan mengeluarkan label kelas yang menerima mayoritas "suara"

2.2.2. Dalam kasus regresi, respon pengklasifikasi adalah rata-rata dari respon atas semua pohon di hutan

2.2.3. Pada dasarnya adalah kombinasi dari dua algoritma yang ada dalam Machine Learning

2.2.3.1. Pohon model tunggal (single model trees) dikombinasikan dengan ide Hutan Acak (Random Forest)

2.2.3.2. Pohon model (model trees) adalah decision tree di mana setiap daun tunggal memegang model linier yang dioptimalkan untuk subruang lokal yang dijelaskan oleh daun ini

3. Rep Tree

3.1. Pengertian

3.1.1. Membangun decision tree/regresi menggunakan information gain/variance dan memangkas menggunakan reduced-error pruning (dengan backfitting)

3.1.1.1. Dianggap sebagai perluasan dari C45 dengan meningkatkan fase pemangkasan dengan menggunakan Reduced Error Pruning (REP)

3.2. Cara Kerja

3.2.1. Untuk setiap sub-pohon, metode ini memeriksa apakah sub-pohon tersebut dapat digantikan oleh satu node, tanpa menurunkan kinerja classifier pada set pemangkasan ini. Dengan demikian, metode pemangkasan ini sederhana, tetapi sering dianggap terlalu agresif, yaitu mungkin menghapus sub-pohon yang sebenarnya relevan

4. Logistic Model Trees (LMT)

4.1. Pengertian

4.1.1. Model klasifikasi dengan algoritma pelatihan terawasi terkait yang menggabungkan regresi logistik (Logistic Regression/LR) dan decision tree (Decision Tree)

4.1.2. LMT memiliki kelemahan yaitu biaya komputasinya yang tinggi, yang membuat algoritma ini kurang praktis

4.2. Cara Kerja

4.2.1. Metode ini menggunakan algoritma LogitBoost untuk membangun fungsi regresi logistik pada sebuah pohon dan menggunakan algoritma CART yang terkenal untuk pemangkasan

4.2.2. Dalam varian logistik, algoritma LogitBoost digunakan untuk menghasilkan model Linear Regression di setiap node di pohon yang Node tersebut kemudian dibagi menggunakan kriteria C4.5 dan dipangkas

4.2.3. Algoritma induksi LMT dasar menggunakan validasi silang untuk menemukan sejumlah iterasi LogitBoost yang tidak terlalu cocok dengan data pelatihan

5. J48 Decision Tree

5.1. Pengertian

5.1.1. Algoritma turunan dari C4.5

5.1.1.1. Dapat melakukan klasifikasi melalui decision tree ataupun rules yang diperoleh dari pohon tersebut

5.2. Cara Kerja

5.2.1. Menetapkan training dataset

5.2.2. Menentukan akar dari decision tree

5.2.3. Menghitung nilai entropy untuk mendapatkan nilai gain

5.2.4. Mulai kembali langkah ke-2 sampai semua tupel terbagi menggunakan persamaan gain

5.2.5. Proses pembagian akan berhenti ketika semua tupel dalam titik N telah memperoleh kelas yang sama dan atau sudah tidak ada atribut dalam tupel yang dibagi lagi atau tidak ada tupel dalam cabang yang kosong

6. Random Forest

6.1. Pengertian

6.1.1. Dapat menangani masalah klasifikasi dan regresi

6.1.1.1. Metode ini menciptakan sebuah hutan (forest) dengan sejumlah pohon (tree)

6.1.1.1.1. Dapat diimplementasikan dalam dunia perbankan, kesehatan, analisis keuangan, dan e-commerce

6.2. Cara Kerja

6.2.1. Random Forest bekerja dengan membangun beberapa decision tree dan menggabungkannya demi mendapatkan prediksi yang lebih stabil dan akurat

6.2.1.1. Semakin banyak pohon (tree) pada sebuah hutan (forest) maka semakin kuat juga hutan tersebut terlihat. Pada kasus yang sama, semakin banyak tree, maka semakin besar pula akurasi yang didapatkan

7. Decision Stump

7.1. Pengertian

7.1.1. Decision tree dengan satu simpul internal (akar) yang langsung terhubung ke simpul terminal (daunnya)

7.1.1.1. Membuat prediksi berdasarkan nilai dari satu fitur input. Hal ini terkadang disebut sebagai 1-rules (OneR)

7.1.1.1.1. *Decision stump* sering digunakan sebagai komponen dalam teknik ensemble machine learning

7.1.2. Istilah *"decision stump" * diciptakan dalam makalah ICML 1992 oleh Wayne Iba dan Pat Langley

7.2. Cara Kerja

7.2.1. Untuk fitur nominal, seseorang dapat membangun stump yang berisi daun untuk setiap nilai fitur yang mungkin atau stump dengan dua daun, yang salah satunya sesuai dengan beberapa kategori yang dipilih, dan daun lainnya untuk semua kategori lainnya

7.2.2. Untuk fitur biner, nilai yang hilang dapat diperlakukan sebagai kategori lain

7.2.3. Untuk fitur kontinu, biasanya, beberapa nilai fitur ambang batas dipilih, dan stump berisi dua daun - untuk nilai di bawah dan di atas ambang batas

8. Paper

8.1. Analysis of WEKA Data Mining Algorithm REPTree, Simple CART and Random Tree for Classification of Indian News

8.1.1. REPTree

8.1.2. Simple CART

8.1.3. RandomTree

8.1.3.1. Terbaik

8.1.3.1.1. Performa dalam mengkategorikan beritanya adalah yang paling akurat